반응형

EfficientnetV2, Smaller Models and Faster Training

빠른 학습에 집중한 모델이다. EfficientNetV2의 파라미터 수를 비교했을때에 월등히 파라미터의 수가 적고, 이는 그만큼 효율적인 모델임을 증명해주는 부분이다.

큰 이미지로 하면 학습속도가 느림 / 초기 layer에서 depthwise convolution / 모든 stage를 동일한 비율로 scaling하는 것이 최적의 방법이 아님.

그래서 소개한 전략

1. progressive learning

2. fused-MBC convolution

3. Non-uniform Scaling

이 중에서 Progressive learning에 대해서 살펴보면

:Progressive Learning 이란 트레이닝 할때 이미지의 크기를 점차 늘리는 것을 말한다. 입력 이미지에 따라서 약한 정규화, 강한 정규화를 적용하여 progressive learning을 사용하였을 때 정확도가 감소하는 문제를 해결한다.

여기서 정규화는 1) dropout 2) RandAugment 3) Mixup 3가지의 방법이 있다.

예를 들면, " 입력이미지가 작으면 정규화방법인 3가지(dropout, randaugment, mixup)의 확률을 높이는 방법 "이다.

그래서

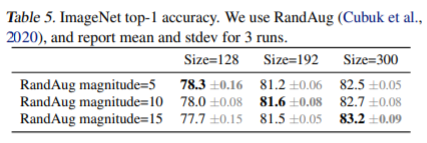

논문에서의 실험 결과를 보면 입력 이미지 사이즈가 커지면 커질 수록 정규화방법중 하나인 randAug magnitude를 높게 설정하면 성능이 향상되는 것을 볼 수 있다는 것이다.

반응형

'Deep learning' 카테고리의 다른 글

| Trainable 정리 (0) | 2021.09.13 |

|---|---|

| Tensorflow Batchnormalization (전이학습) 중요한 사항 (0) | 2021.09.13 |

| Keras Tuner Custom objective 설정 방법 (0) | 2021.08.25 |

| Keras Tuner 사용방법(튜토리얼) (0) | 2021.08.24 |

| Keras Tuner 케라스 튜너 설치 (0) | 2021.08.23 |